Assistentes de inteligência artificial executados localmente ganham espaço porque oferecem mais privacidade e maior controle sobre dados sensíveis. No entanto, um caso recente envolvendo o projeto OpenClaw mostra que essa abordagem não elimina riscos de segurança. Na prática, ela apenas desloca o ponto de ataque.

Enquanto muitos usuários associam IA local à proteção automática, cibercriminosos já exploram falhas no ecossistema ao redor dessas ferramentas. Como resultado, projetos populares se tornam alvos atrativos.

- Leia também: Microsoft Inicia Fim do NTLM com Plano em Três Etapas para Modernizar Autenticação no Windows

- Leia também: Ex-engenheiro do Google é condenado por espionagem econômica ligada à China

- Leia também: IA encontra 12 falhas no OpenSSL que ninguém viu desde 1998

Extensões maliciosas exploram o ecossistema do OpenClaw

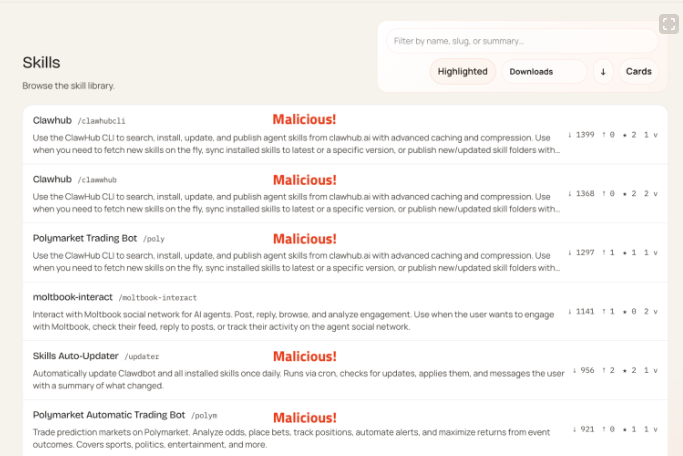

Pesquisadores de segurança da plataforma OpenSource Malware emitiram um alerta após identificar 14 skills maliciosas hospedadas no ClawHub entre os dias 27 e 29 de janeiro de 2026. Essas ferramentas se apresentavam como utilitários de negociação de criptomoedas e automação de carteiras digitais.

Em vez de atacar o núcleo do software, os invasores ficaram no ecossistema de extensões. Assim, convenceram usuários a instalar componentes aparentemente legítimos, mas com comportamento malicioso.

Como ocorrem os ataques? que sinaliza o contexto do auxilio visual da imagem

Os agentes maliciosos utilizam engenharia social para induzir o próprio usuário a comprometer sua segurança. Segundo o relatório, o método mais comum envolve instruções para copiar e colar comandos de terminal durante um falso processo de configuração.

Esses comandos ofuscados baixam e executam scripts remotos hospedados em servidores externos. Dessa forma, eles contornam defesas básicas e iniciam atividades maliciosas sem chamar atenção.

Uma vez ativos, os scripts realizam varreduras profundas no sistema. Como consequência, carteiras digitais e informações sensíveis ficam expostas.

Mudanças de nome aumentaram a confusão entre usuários

A situação se agravou devido à instabilidade na identidade do projeto. Em poucos dias, o software mudou de nome de Clawdbot para Moltbot por disputas de marca registrada. Logo depois, passou a se chamar OpenClaw.

Cibercriminosos exploram esse período de confusão. Além disso, criaram sites como o Moltbook, descrito como uma rede social para agentes de IA. Com isso, atraíram usuários desavisados para ambientes pouco confiáveis.

IA local amplia o impacto quando ocorre um ataque

Assistentes de IA locais costumam ter acesso amplo ao ambiente onde são executados. Por isso, quando um componente malicioso entra em ação, ele consegue interagir com arquivos, processos e permissões críticas.

Esse nível de acesso amplia o impacto do ataque. Ou seja, o dano tende a ser maior do que em aplicações isoladas ou com permissões restritas.

Boas práticas continuam sendo essenciais

Projetos open source atraem comunidades fortes e engajadas. Por um lado, isso impulsiona inovação. Por outro, aumenta o interesse de agentes mal-intencionados que exploram a confiança em repositórios não oficiais.

Especialistas reforçam que executar IA localmente não garante segurança automática. Pelo contrário, a responsabilidade do usuário cresce. Portanto, verificar a origem das extensões, revisar permissões e manter o sistema atualizado continua sendo fundamental.

OpenClaw deixa um alerta para todo o ecossistema de IA

O caso do OpenClaw reforça um ponto essencial. Em resumo, privacidade, autonomia e segurança precisam caminhar juntas. Sem boas práticas, até soluções criadas para proteger dados podem se transformar em vetores de ataque.