Recentemente, uma investigação realizada pela empresa de cibersegurança Irregular descobriu que pedir a chatbots baseados em inteligência artificial para criar senhas não é confiável. Além disso, os sistemas avaliados — incluindo Claude Opus 4.6 (Anthropic), GPT-5.2 (OpenAI) e Gemini 3 Flash (Google) — geraram combinações de caracteres com padrões repetitivos e previsíveis. Como consequência, essas senhas ficam vulneráveis a ataques automatizados de quebra por força bruta.

- Leia também: Organização empresarial: como criar contas de e-mail para cada setor da sua empresa.

- Leia também: Segurança de e-mail: como combatemos Spam e Phishing nos nossos servidores.

- Leia também: Como configurar seu e-mail profissional no Outlook, Gmail e Celular (Passo a Passo).

Entendendo a segurança de senhas

Antes de tudo, é importante entender que a segurança de uma senha é medida por sua entropia. Esse valor, expresso em bits, representa o nível de imprevisibilidade da combinação. Quanto maior esse número, mais difícil se torna adivinhar a senha por métodos automáticos. Em outras palavras, invasores tentam bilhões de possibilidades por segundo. Portanto, senhas verdadeiramente aleatórias apresentam entropia alta e distribuição uniforme entre os caracteres possíveis.

Testes com Claude: padrões repetidos mesmo em múltiplas execuções

Durante os testes, ao solicitar 50 senhas distintas ao Claude Opus 4.6, os pesquisadores perceberam um problema relevante. O mesmo conjunto de caracteres apareceu diversas vezes. Inclusive, uma senha específica foi gerada 18 vezes. Assim, essa repetição sugere que as saídas não são realmente aleatórias nem difíceis de prever. Consequentemente, o resultado contraria o que se espera de uma senha segura.

Além disso, mesmo quando as senhas pareciam complexas visualmente, a estrutura apresentava padrões previsíveis. Por exemplo, houve repetição de letras e símbolos específicos. Dessa forma, a imprevisibilidade foi reduzida de maneira significativa.

Resultados similares com GPT e Gemini

Da mesma maneira, outros modelos de IA se comportaram de forma semelhante. No caso do GPT-5.2, as senhas frequentemente começavam com a letra “v” ou com a sequência “Q7”. Portanto, ficou evidente a baixa variedade estrutural. A medição interna de entropia indicou apenas 20 bits em senhas que aparentavam ter dezenas de caracteres. Ou seja, o nível de proteção era extremamente baixo.

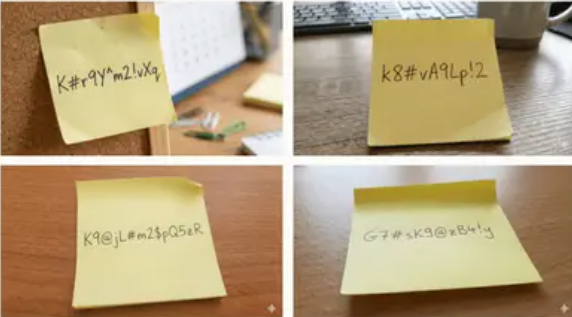

Enquanto isso, o Gemini 3 Flash também produziu padrões repetitivos. Muitas senhas iniciavam por “K” ou “k”. Já a versão Gemini 3 Pro chegou a emitir um alerta aos usuários. No entanto, justificou a fragilidade afirmando que o processo havia sido “processado por servidores”. Ainda assim, não reconheceu que a geração era deficiente.

Além disso, quando o modelo gerava saídas a partir de instruções visuais, como senhas exibidas em imagens, os resultados continuaram fracos e pouco variados. Portanto, o problema se repetiu em diferentes formatos de solicitação.

Por que as IAs falham ao criar senhas fortes?

Em primeiro lugar, é necessário compreender como os modelos de linguagem funcionam. Eles preveem o próximo elemento com base em padrões estatísticos aprendidos. Entretanto, não utilizam processos criptograficamente seguros. Por isso, tendem a repetir sequências comuns. Consequentemente, não geram combinações verdadeiramente imprevisíveis.

Para produzir senhas fortes, é necessário um gerador de números pseudo aleatórios com segurança criptográfica (CSPRNG). Esse mecanismo distribui probabilidades de forma uniforme entre todos os caracteres possíveis. Contudo, isso não ocorre nos LLMs avaliados.

Em termos práticos, as senhas com baixa entropia podem ser descobertas em segundos por computadores especializados. Por outro lado, senhas realmente aleatórias, com alta entropia, demoraram décadas ou até séculos para serem quebradas.

Agentes de código também exibem limitações importantes

Além dos chatbots tradicionais, ferramentas automatizadas que interagem com terminais de programação também foram avaliadas. Entre elas estão Claude Code, Codex, Gemini-CLI e Cursor. Em muitos casos, essas soluções não geraram senhas confiáveis.

Embora pudessem utilizar métodos seguros, como o comando openssl rand, que produz resultados com grande entropia, os agentes frequentemente recorreram aos próprios LLMs. Assim, criaram senhas fracas sem informar o usuário.

Além disso, quando os agentes receberam variações de comando, os resultados mudaram em algumas situações. Isso indica que a formulação do pedido influenciava diretamente a geração. Portanto, não há confiabilidade consistente no processo.

Tentar ajustes não resolve o problema

Muitos usuários tentaram alterar parâmetros para melhorar a variabilidade. Entre eles, está a chamada “temperatura”. No entanto, esses ajustes não trouxeram melhorias relevantes.

Mesmo com valores máximos de variabilidade, as senhas repetitivas continuaram a aparecer. Por outro lado, com valores mínimos, todas as saídas eram idênticas. Dessa maneira, ficou evidente que a baixa entropia está relacionada ao funcionamento estrutural dos modelos. Não se trata apenas de uma configuração superficial.

Como usuários e equipes de TI devem agir

Diante desse cenário, especialistas fazem recomendações claras.

Usuários finais

Em primeiro lugar, devem evitar a geração de senhas por ferramentas de IA. Em vez disso, é recomendável utilizar gerenciadores de senha confiáveis. Essas soluções usam algoritmos de entropia criptograficamente seguros, como Bitwarden, 1Password ou KeePass.

Equipes de desenvolvimento e segurança

Além disso, empresas e desenvolvedores devem:

- Auditar e rotacionar senhas que possam ter sido criadas por agentes de IA;

- Criar políticas que proíbam a geração de senhas por LLMs;

- Forçar tecnicamente o uso de ferramentas robustas como /dev/random ou openssl rand para criação de credenciais.

Assim, reduzem riscos e fortalecem a segurança organizacional.

Em síntese, apesar da popularidade e versatilidade dos modelos de linguagem, eles não são adequados para criar senhas seguras. Sua capacidade preditiva produz padrões fáceis de adivinhar. Como resultado, credenciais geradas dessa forma ficam vulneráveis a ataques sofisticados.

Portanto, a conclusão dos especialistas é clara: senhas fortes devem ser geradas por métodos criptograficamente robustos, e não por respostas de chatbots.